در دنیای پرشتاب هوش مصنوعی، یک نام به تازگی خودنمایی میکند: هوش مصنوعی دیپ سیک. این شرکت چینی، با مدلهای هوش مصنوعی نوآورانهاش، توجهها را به خود جلب کرده و به چالشی جدی برای برتری ایالات متحده در این عرصه تبدیل شده است.

در ماههای اخیر بارها نام هوش مصنوعی دیپ سیک در خبرها و محافل مطرح شده بود اما تا به امروز هیچ کس متوجه اهمیت این نام نشده بود و به نظر میرسید که این شرکت هم صرفا یک استارتآپ ناشناس دیگر باشد که مدلهای نهچندان متمایزی ارایه میکند. دستکم طی یک ماه گذشته به نظر میرسید که در حد OpenAI و گوگل نیست و و اغلب کارشناسان باور داشتند که فاصلهی زمانی زیادی برای رسیدن DeepSeek به این سطح وجود دارد؛ اما حقیقت این است که همه در محاسبات خود دچار اشتباه شده و این تیم را دست پایین گرفته بودند. دانشمندان دیپ سیک به شکل غیرقابل باوری سریع بودند.

به هر صورت، دیگر نمیتوان هوش مصنوعی دیپ سیک را نادیده گرفت. نه به این خاطر که شرکتی چینی است، بلکه به دلیل این که مدلهایی که تولید کردهاند، هم کیفیت بالایی دارند و هم به صورت متنباز در اختیار عموم قرار گرفتهاند. علاوه بر این، هزینهی ساخت آنها نیز بسیار پایین است.

هوش مصنوعی دیپ سیک در رقابت با OpenAI

در تاریخ ۲۰ ژانویه ۲۰۲۵، دیپ سیک مدل استدلالی خود، DeepSeek-R1 را معرفی کرد. این مدل از نظر عملکردی معادل OpenAI o1 است که در ۵ دسامبر ۲۰۲۴ منتشر شده بود. فاصلهی زمانی بین این دو مدل تنها یک ماه است، فاصلهای که بهشدت قابل توجه است و نشان میدهد که آزمایشگاههای بستهی آمریکایی و جامعهی متنباز هوش مصنوعی تنها مدت کوتاهی از یکدیگر فاصله دارند. همچنین، این موضوع تفاوت زمانی بین ایالات متحده و چین در رقابت برای توسعهی هوش مصنوعی را برجسته میکند.

البته برخی از کارشناسان چنین اتفاقی را پیشبینی کرده بودند، اما حتا آنها نیز انتظار نداشتند که چنین چیزی به این زودی رخ دهد؛ چرا که خود OpenAI دستکم شش ماه از دیگر شرکتهای آمریکایی جلوتر بود و دیگر این که همه یقین داشتند شرکتهای چینی مانند علیبابا و تنسنت بیش از یک سال عقبتر از همتایان غربی خود هستند.

اما برخی خبرگان از مدتها قبل چنین وضعیتی را پیشبینی کرده بودند. سم آلتمن، مدیرعامل OpenAI، در مقالهای در واشنگتنپست در ژوییه ۲۰۲۴ هشدار داده بود که «یک رویکرد دموکراتیک برای هوش مصنوعی باید بر نسخهی اقتدارگرایانه آن غلبه کند.۱» او هم چنین هشدار داد که «ایالات متحده در حال حاضر در صدر توسعهی هوش مصنوعی قرار دارد، اما ادامهی این پیشتازی هیچ تضمینی ندارد.۲» و به این واقعیت اشاره کرد که «چین بهصورت علنی اعلام کرده که قصد دارد تا سال ۲۰۳۰ در این حوزه به رهبر جهانی تبدیل شود.۳» حالا به نظر میرسد که حتی خود آلتمن نیز از پیشرفت دیپ سیک شگفتزده شده باشد.

این نکته نیز بسیار جالب توجه است که OpenAI هنوز هم تحقیقات پیشرفتهی خود را پشت درهای بسته نگه میدارد، حتا از دیگر شرکتهای آمریکایی، در حالی که دیپ سیک مدل R1 را کاملا متنباز منتشر کرده و به جهان اجازه داده است که آزادانه از آن استفاده کند.

چین در مسیر AGI: پیشی گرفتن از آمریکا یا بهرهبرداری از مسیر غرب؟

سه پرسش کلیدی که باید در این زمینه مطرح کرد:

- آیا چین واقعا قصد دارد مستقیما در مسیر AGI۴ از ایالات متحده جلو بزند، یا فقط از مزیت استفاده از دستاوردهای شرکتهای آمریکایی بهره میبرد؟

- آیا دیپ سیک مدلهایش را متنباز کرده تا زیستبوم جهانی هوش مصنوعی را تغذیه کند، یا این حرکتی تبلیغاتی برای جلب توجه است، قبل از آن که مدلهایش را ببندد؟

- چه گونه این شرکت توانسته مدلهایی به این سطح از کیفیت را این قدر سریع و ارزان توسعه دهد؟ آیا روشی را کشف کرده که آزمایشگاههای غربی از آن بیاطلاعاند؟

اکنون که ابعاد ژئوپلیتیکی این موضوع را بررسی کردیم، بیایید روی مهمترین بخش متمرکز شویم: مقایسهی فنی مدلها

مقایسه R1 و o1: آیا هوش مصنوعی دیپ سیک رقیب OpenAI است؟

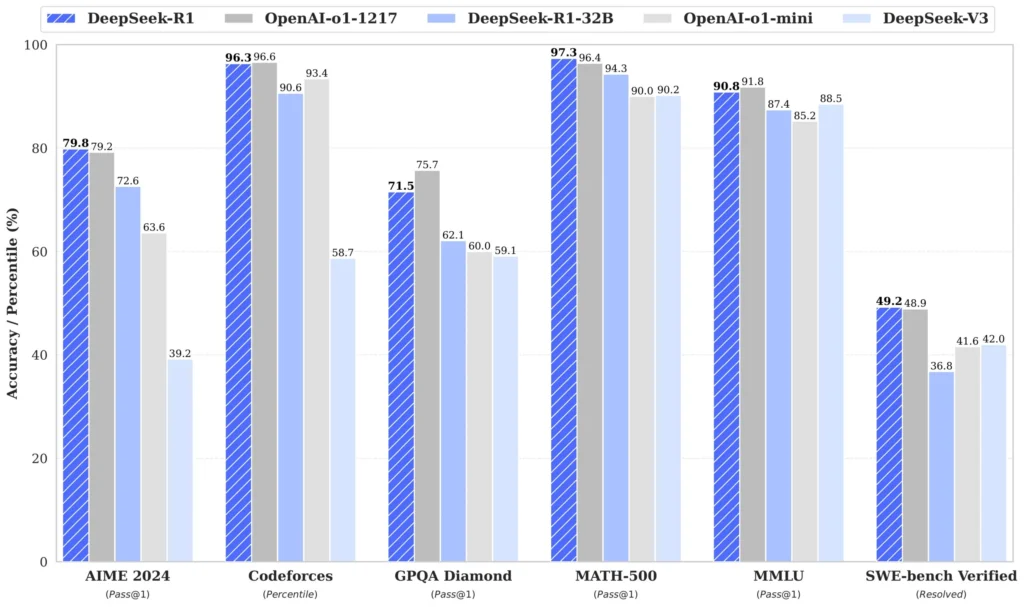

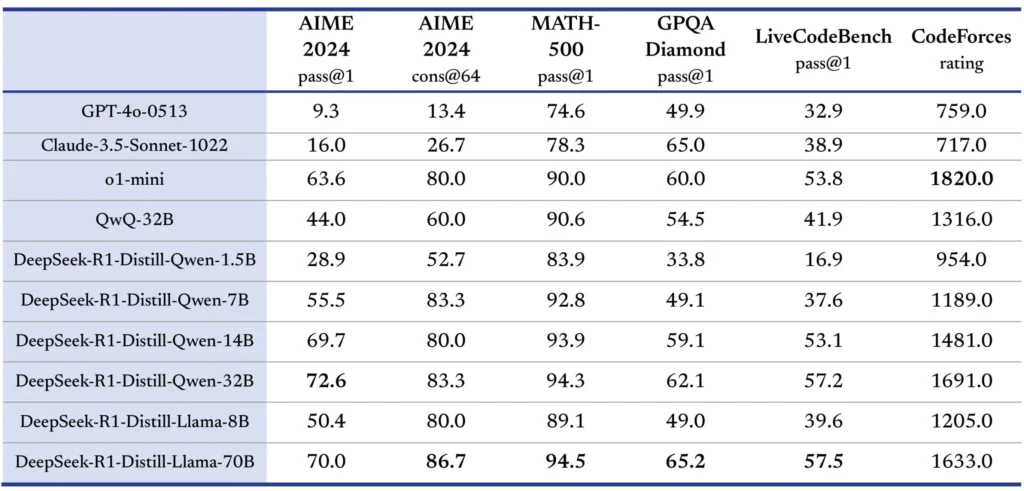

دیپ سیک دادههای مقایسهای بین R1 و o1 را در شش معیار مهم (از جمله GPQA Diamond و SWE-bench Verified) و برخی دیگر از آزمونهای جایگزین (مثل Codeforces و AIME) منتشر کرده است. این لیست فاقد برخی معیارهای مطرح مانند ARC-AGI و FrontierMath است، که به احتمال زیاد به این دلیل حذف شدهاند که OpenAI در این زمینهها مزیت رقابتی ناعادلانهای دارد.

نتایج کلیدی:

- R1 و o1 تقریبا عملکردی یکسان دارند، با تفاوت ناچیز ۴ درصدی در GPQA Diamond (۷۱.۵٪ در مقابل ۷۵.۷٪ به نفع OpenAI o1).

- در مقایسه با GPT-4o، فاصله عملکردی در برخی معیارها به طرز چشمگیری زیاد است:

- ۸۵٪ شکاف در Codeforces (کدنویسی)

- ۷۵٪ شکاف در AIME (ریاضیات)

- ۱۵٪ شکاف در GPQA Diamond (علوم)

به طور خلاصه، دیپ سیک مدلی در حد بهترین مدل OpenAI توسعه داده که در بین آزمایشگاههای ایالات متحده نیز برجسته محسوب میشود. البته، OpenAI پیشتر اعلام کرده که مدل o3 را معرفی خواهد کرد که انتظار میرود عملکرد بسیار بهتری از o1 داشته باشد، اما هنوز منتشر نشده است. در عین حال، دیپ سیک با انتشار متنباز R1، عملا این فناوری را در اختیار عموم قرار داده است.

توسعه و مدلهای جایگزین

نکته مهم: دیپ سیک تنها به انتشار R1 بسنده نکرده، بلکه مدل R1-Zero را نیز منتشر کرده که برخلاف نسخهی استاندارد، بدون استفاده از دادههای برچسبگذاریشده انسانی آموزش دیده است. این مدل به نوعی مشابه AlphaGo Zero است که بدون استفاده از بازیهای انسانی یاد گرفت و توانست نسخهی انسانیتر خود را شکست دهد.

R1 تنها یکی از هشت مدلی است که دیپ سیک متنباز کرده است. یکی از مهمترین آنها R1-Zero است که تفاوت اصلی آن با R1 در این است که R1-Zero در مرحلهی آموزش پس از تمرین، از دادههای برچسبگذاریشدهی انسانی استفاده نکرده است؛ به عبارت دیگر، دیپ سیک به این مدل اجازه داده است بهصورت مستقل روشهای استدلالی خود را کشف کند.

علاوه بر این، دیپ سیک شش مدل دیگر را نیز توسعه داده که بر پایه مدلهای ضعیفتر (مانند Qwen و Llama) و با استفاده از دادههای تقطیرشدهی R1 آموزش داده شدهاند. تقطیر۵، فرایندی است که در آن یک مدل بزرگتر و قدرتمند، یک مدل کوچکتر را با دادههای مصنوعی آموزش میدهد. این روند بهطور خاص در مقالهای درباره GPT-5 مورد بحث قرار گرفته است. نتایج این مدلهای تقطیرشده نشان میدهد که آنها عملکردی بهمراتب بهتر از مدلهای پایهی خود دارند، که این موضوع میتواند شواهدی بر وجود و استفاده داخلی از GPT-5 برای تقطیر مدلهای کوچکتر باشد.

مزیت هزینهای R1

یکی از جنبههای قابل توجه هوش مصنوعی دیپ سیک R1، کارایی بالای آن نسبت به هزینه است. دیپ سیک موفق شده R1 را با تنها ۵ تا ۱۰ درصد هزینهی o1 توسعه دهد. این امر مشابه تولید یک گوشی هوشمند با کیفیت مشابه Google Pixel یا Apple iPhone با قیمت ۵۰ دلار است. پرسشهای بسیاری در این زمینه مطرح است: آیا دیپ سیک با ضرر کار میکند؟ آیا آنها روشی بهینه برای توسعهی مدلهای زبانی یافتهاند که از چشم گوگل و اوپنایآی پنهان مانده است؟ یا این که آنها استراتژی متا در تجاریسازی مدلهای زبانی را دنبال میکنند؟

R1-Zero و مسیر جدید استدلال ماشینی

رویکرد دیپ سیک در توسعه R1 و R1-Zero، شباهت زیادی به استراتژی Google DeepMind در توسعهی AlphaGo و AlphaGo Zero دارد. هر دو مدل R1 و R1-Zero دارای مرحلهی پیشآموزش مشترک هستند، اما تفاوت اصلی در مرحلهی پس از آموزش آنها نهفته است:

- هوش مصنوعی دیپ سیک R1 پس از پیشآموزش، از مقدار کمی دادهی انسانی برای تنظیم دقیق نظارتشده (SFT) استفاده کرده است.

- هوش مصنوعی دیپ سیک R1-Zero بدون استفاده از دادههای انسانی، مستقیما به مرحلهی یادگیری تقویتی (RL) هدایت شده است و بهصورت خودکار فرآیند استدلال را فراگرفته است.

نتایج به دست آمده از این روش نشان میدهد که مدل هوش مصنوعی دیپ سیک R1-Zero قادر به توسعهی مهارتهای استدلالی بدون نیاز به دادههای نظارتشدهی انسانی است. این موضوع میتواند گامی مهم در مسیر توسعهی مدلهایی باشد که بدون وابستگی به دانش انسانی، قادر به کشف روشهای استدلالی جدید باشند.

بیایید کمی فنیتر شویم (البته نه بیش از حد) و ببینیم تفاوت R1 و R1-Zero در چیست. هر دو یک مرحلهی پیشآموزش دارند (که شامل پردازش حجم عظیمی از دادههای اینترنتی است) و یک مرحلهی پسآموزش. مرحلهی اول برای هر دو یکسان است؛ هر دو مدل بر پایهی DeepSeek-V3 ساخته شدهاند. اما تفاوت در مرحلهی دوم است.

در مورد هوض مصنوعی دیپ سیک R1، پس از پیشآموزش، به مدل مقدار کمی دادهی انسانی با کیفیت بالا داده شد (یک مرحلهی تنظیم دقیق نظارتشده یا SFT). این همان روشی است که به صورت معمول برای تبدیل یک مدل پایه (مثل GPT-4 خام) به یک مدل چت (مثل ChatGPT) استفاده میشود، اما در مقیاس بسیار بزرگتر.

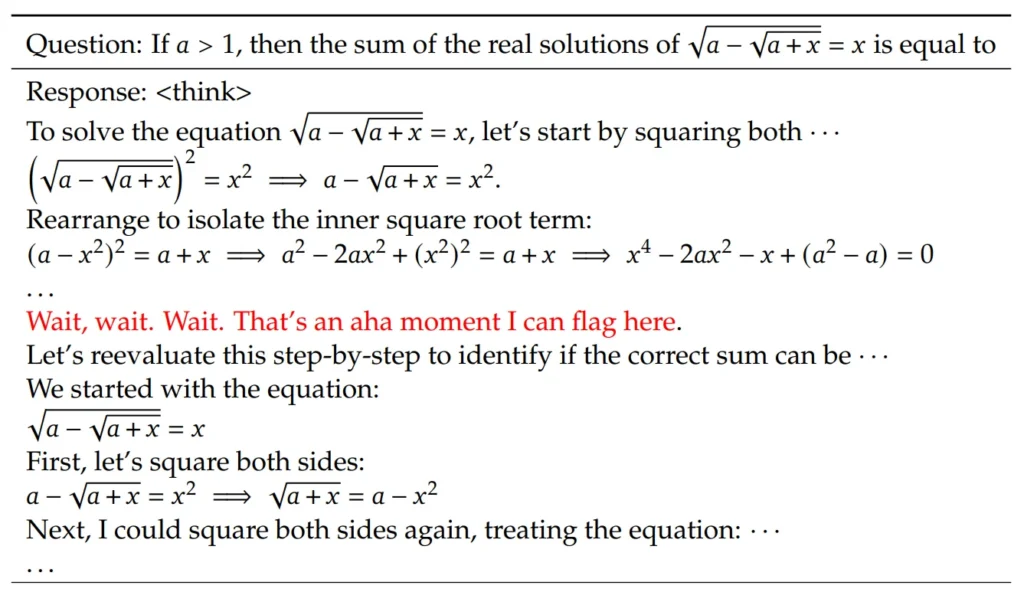

دیپ سیک سعی کرد این مرحله را تا حد امکان کوچک نگه دارد. سپس، برای بهبود توانایی استدلال R1، یک لایهی یادگیری تقویتی (RL) اضافه کردند. البته این یادگیری تقویتی بسیار ساده بود؛ خبری از تکنیکهای پیچیدهای مثل MCTS یا PRM نیست (نیازی هم به جستوجوی این اصطلاحات ندارید!). در کنار آن، به مدل اجازه دادند که هنگام پاسخ دادن، بیشتر فکر کند، روشی که با نام TTC شناخته میشود و اوپنایآی آن را با مدل o1 معرفی کرد. نتیجه؟ R1 یک مدل چت پیشرفته شد که ترکیبی از یادگیری انسانی و بهینهسازی ماشینی را در خود دارد.

اما R1-Zero چه طور؟ این مدل همان R1 است، با این تفاوت که هیچ دادهی انسانی (SFT) به آن داده نشده است. یعنی چه؟

به زبان ساده:

- R1 ابتدا در اینترنت بهدنبال اطلاعات گشت (پیشآموزش)، سپس یک راهنمای استدلال انسانی را خواند (SFT) و درنهایت خودش را با تمرین بیشتر بهبود داد (RL + TTC).

- اما R1-Zero هیچ کتابچهی راهنمایی نخواند! پس از پیشآموزش روی دادههای اینترنت، مستقیما وارد مرحلهی یادگیری تقویتی شد، با این پیام: «برو و خودت یاد بگیر چه طور استدلال کنی!»

این رویکرد یادآور کاری است که DeepMind در سال ۲۰۱۶-۲۰۱۷ انجام داد. مدل AlphaGo یادگیری خود را از طریق مسابقات انسانی آغاز کرد، اما AlphaGo Zero فقط قوانین بازی را دریافت کرد و بدون هیچ دادهی انسانی، خودش یاد گرفت و درنهایت آلفاگو را شکست داد.

اما اینجا یک تفاوت اساسی وجود دارد:

یادگیری استدلال باز بسیار سختتر از یادگیری یک بازی مثل «گو» است. نتیجه؟ R1-Zero در استدلال کمی ضعیفتر از R1 عمل میکند و مشکلاتی مانند خوانایی پایین در متنهایش دیده میشود.

علاوه بر این، هر دو مدل هنوز بهشدت به دادههای انسانی در مرحلهی پیشآموزش وابسته هستند. یعنی ما هنوز فاصلهی زیادی تا هوش مصنوعیای داریم که بتواند از هیچ، تمدن بشری را بازسازی کند – فقط با استفاده از قوانین فیزیک!

حالا بیایید ببینیم R1 و R1-Zero در عمل چه تفاوتهایی دارند …

آیندهی هوش مصنوعی: تفکر فراتر از انسان

حتا با وجود همهی پیچیدگیها، موفقیت هوش مصنوعی دیپ سیک R1-Zero قابل توجه است. تیم دیپ سیک در مورد این مدل میگوید:

نتایج نشان میدهد که یادگیری تقویتی (RL) به R1-Zero امکان میدهد تا به تواناییهای استدلالی قوی بدون نیاز به دادههای انسانی دست یابد. این پیشرفتی بزرگ است؛ زیرا نشان میدهد مدل میتواند تنها با تکیه بر RL به یادگیری و تعمیم مؤثر برسد.

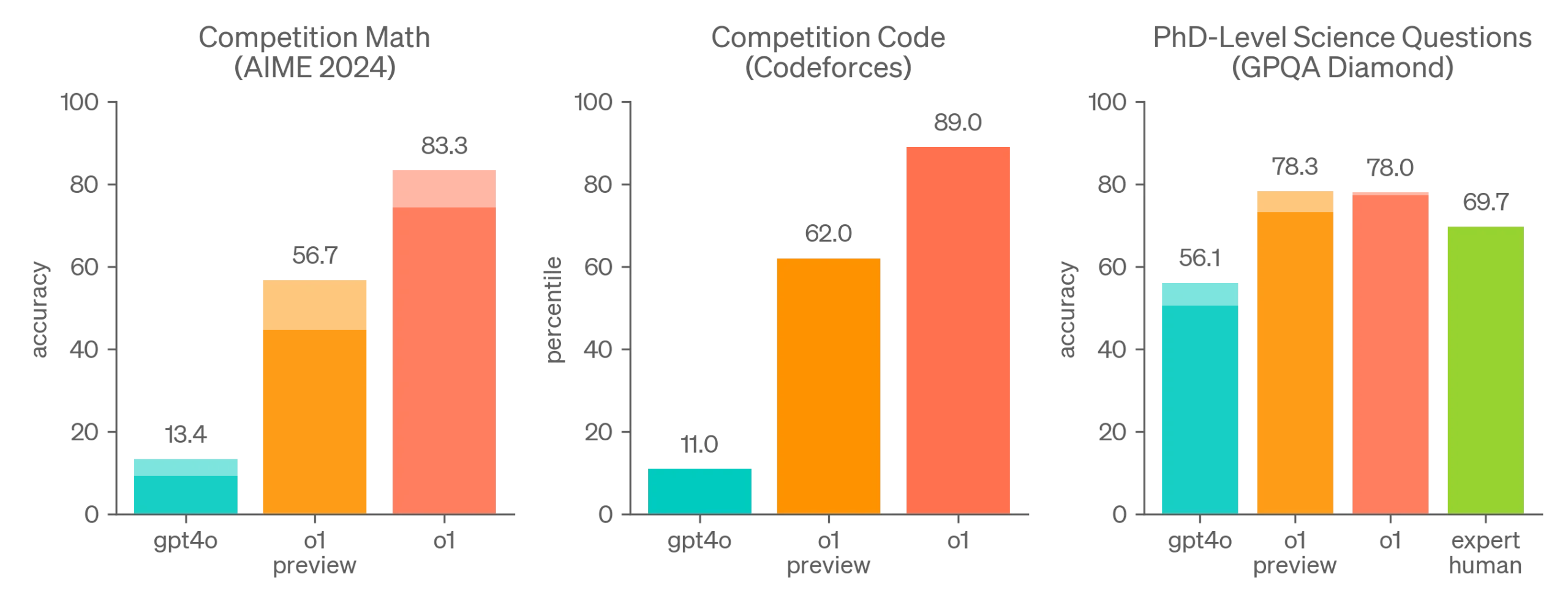

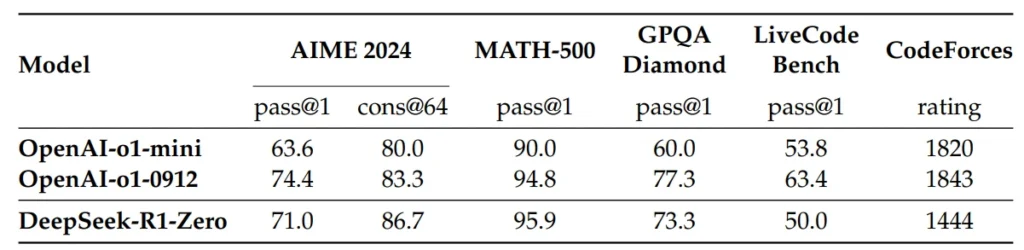

تا جایی که میدانیم، OpenAI این رویکرد را امتحان نکرده است. آنها بهجای آن از الگوریتمهای پیچیدهتر RL استفاده میکنند. در اینجا میتوانید نتایج عملکرد R1-Zero را در مقایسه با مدل o1-preview مشاهده کنید:

اما فرض کنید مدل هوش مصنوعی دیپ سیک R1-Zero بهتر عمل میکرد؛ اگر میتوانستیم با نمایش کل اینترنت به مدل و سپس درخواست از آن برای یادگیری شیوهی استدلال از طریق RL ساده، بدون نیاز به دادههای انسانی، به نتایج بسیار بهتری دست یابیم چه؟ حتا فرض کنید که نیازی به پیشآموزش هم نداشتیم! البته این شاید شبیه به داستانهای علمی تخیلی آسیموف به نظر برسد، اما چرا که نه؟

به جای نشان دادن میلیونها نمونه از زبان و استدلال انسانی به مدلهای Zero، چرا به آنها قوانین پایهای منطق، استنتاج، مغالطات، سوگیریهای شناختی، روش علمی و اصول فلسفی را آموزش ندهیم؟ شاید این مدلها بتوانند راههای جدیدی برای تفکر کشف کنند که ما انسانها هرگز به آنها دست نیافتهایم.

یکی از مسایل کلیدی که این تحقیقات مطرح میکند، امکان ظهور روشهای جدید و غیرانسانی برای استدلال در مورد جهان است. همان گونه که AlphaZero سبک جدیدی از بازی شطرنج را ارایه داد که برای استادان بزرگ نیز شگفتانگیز بود، ممکن است در آینده هوش مصنوعی بتواند روشهایی برای تفکر ارایه کند که نهتنها کارآمدتر، بلکه به کلی غیرقابل درک برای انسانها باشد.

بیایید بیشتر به این ایده بپردازیم. اگر مدلهای نوع Zero هر چه پیشرفتهتر میشوند، بهجای این که شبیهتر به انسان شوند، عجیبتر و غیرقابلفهمتر شوند، چه؟

هنگامی که هوش مصنوعی دیپ سیک R1-Zero آموزش داده شد، خواندن پاسخهای آن چالشبرانگیز شد؛ چرا که مدل شروع به ترکیب زبانها کرد. این موضوع دوباره DeepMind را یادآوری میکند. AlphaGo Zero بهتر از AlphaGo بازی میکرد، اما بازیاش برای انسانها عجیبتر به نظر میرسید. در حالی که آلفاگو از بازیهای انسانی آموخته بود، آلفاگوزیرو مجبور شد تنها از طریق بازی با خودش یاد بگیرد. بدون دادههای ما، نقصهای ما را نداشت و مهمتر از همه، رفتار ما را نیز نداشت.

پس این پرسش پیش میآید: آیا روشهای غیرانسانی برای درک جهان وجود دارند که کارآمدتر از روشهای انسانی باشند؟ آیا هوش مصنوعی هرچه باهوشتر میشود، برای ما غیرقابلدرکتر میشود؟

فکر میکنم جواب مثبت باشد. پیشرفت هوش مصنوعی شامل دو مرحله است. در مرحلهی اول، مدل به طرز عجیبی به ویژگیهای انسانی نزدیک میشود؛ مثل این که در حال تفکر و بررسی رویکردهای مختلف برای حل مسایل است. اما مرحلهی دوم جایی است که مدلها از درک انسانی فراتر میروند.

این سناریو پرسشهای مهمی را مطرح میکند:

- آیا روشهای استدلالی بهتر و کارآمدتری نسبت به شیوههای انسانی وجود دارد؟

- آیا پیشرفت در هوش مصنوعی باعث میشود این مدلها از نظر شناختی برای ما بیگانه شوند؟

- آیا باید انتظار داشته باشیم که مدلهای هوش مصنوعی از زبانهای بشری عبور کرده و به روشهای جدیدی برای تفکر و پردازش اطلاعات دست یابند؟

نتایج حاصل از مدل هوش مصنوعی دیپ سیک R1-Zero نشان میدهد که این امکان وجود دارد که هوش مصنوعی در آینده به روشهایی برای پردازش اطلاعات دست یابد که برای ما غیرقابل درک باشد. اگر چنین اتفاقی بیافتد، باید خود را برای مرحلهای جدید در تکامل هوش مصنوعی آماده کنیم؛ مرحلهای که در آن، روشهای استدلال ماشینی از محدودهی درک انسانی فراتر خواهند رفت.

در کنار این پیشرفتها، چالشهای متعددی نیز مطرح است. برای مثال:

- مسایل اخلاقی: آیا باید به هوش مصنوعی اجازه داده شود که بدون مداخلهی انسانی، مسیر خود را طی کند؟

- قابلیت کنترل: آیا میتوان مدلهایی مانند R1-Zero را که روشهای استدلالی جدیدی کشف میکنند، کنترل کرد؟

- شفافیت و فهمپذیری: اگر این مدلها به شیوهای استدلال کنند که برای ما قابل درک نیست، آیا همچنان باید به آنها اعتماد کنیم؟

در نهایت، وقتی هوش مصنوعی از مرزهای درک ما عبور کند، برایمان عجیب خواهد شد. از آنچه منطقی به نظر میرسد، فراتر میرود – درست مثل آلفاگو زیرو.

شاید اوپنایآی زنجیرهی تفکر o1 را تنها به دلایل رقابتی پنهان نکرده باشد، بلکه به این دلیل که به یک حقیقت ترسناک پی برده است: این که دیدن یک مدل که از انگلیسی به زبانهای دیگر میپرد، بعد به نمادها و در نهایت به چیزی که در ظاهر بیمعنا به نظر میرسد؛ میتواند ما را به وحشت بیندازد.

«چه اتفاقی افتاد؟ چطور به این جواب رسیدی؟ من هیچی نفهمیدم!»

هیچ کس دوست ندارد مستقیم به ذهن موجودی فراتر از خود نگاه کند. هیچ کس نمیخواهد چیزی ببیند که مغزش را تا مرز جنون پیش ببرد.

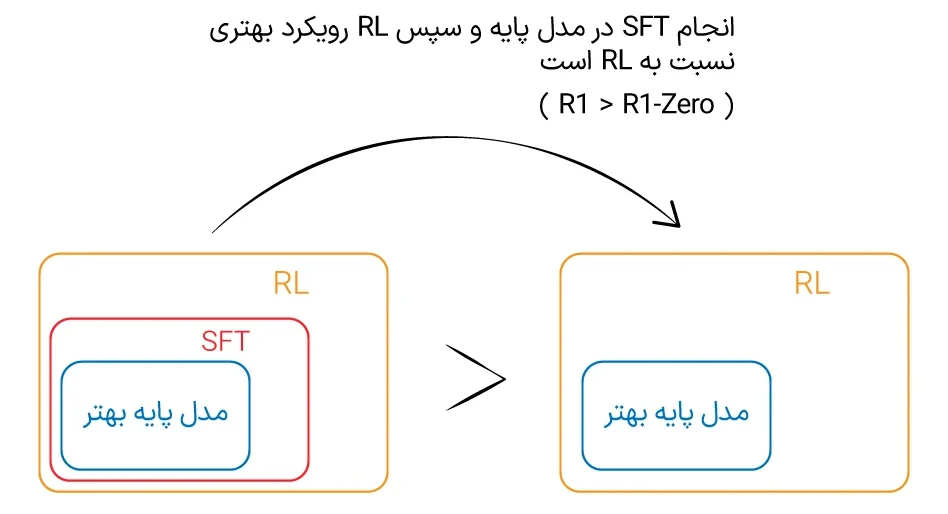

مدلهای پایهی بهتر + تقطیر + RL؛ ترکیب برنده

فارغ از بحثهای علمیتخیلی، یک نکتهی دیگر این است که دیپ سیک خیلی صریح توضیح داده که چه چیزی در ساخت R1، R1-Zero و مدلهای تقطیرشده جواب داده و چه چیزی کار نکرده است. تمام رازها همین جا هستند.

علاوه بر آن چه پیشتر گفته شد، سه نکتهی کلیدی دیگر هم از نتایج آنها مشخص است:

۱. تقطیر از یک مدل قویتر، بسیار موثرتر از اعمال مستقیم RL روی یک مدل ضعیفتر است.

به عبارت دیگر، اگر میخواهید یک مدل کوچکتر و ضعیفتر را ارتقا دهید، نباید از همان روشی استفاده کنید که برای ساخت مدل بزرگتر به کار رفته است. بلکه باید مدل بزرگتر را به عنوان معلم استفاده کنید:

با استفاده از Qwen2.5–32B به عنوان مدل پایه، تقطیر مستقیم از مدل هوش مصنوعی دیپ سیک-R1 عملکرد بهتری نسبت به اعمال RL بر روی آن دارد. این نشان میدهد که الگوهای استدلالی کشفشده توسط مدلهای پایهی بزرگتر برای بهبود قابلیتهای استدلالی بسیار مهم هستند … تقطیر از مدلهای قویتر به مدلهای کوچکتر نتایج عالی میدهد، در حالی که مدلهای کوچکتر که تنها بر RL در مقیاس بزرگ متکی هستند، هم به توان محاسباتی زیادی نیاز دارند و هم شاید هرگز به عملکرد تقطیر نرسند.

۲. اما این بدان معنا نیست که RL روی مدلهای کوچکتر کاملا بیفایده است.

حتی بعد از تقطیر، همچنان RL میتواند کارایی مدل را افزایش دهد. دیپ سیک خودش میگوید:

ما دریافتیم که اعمال RL بر روی مدلهای تقطیرشده دستاوردهای قابلتوجهی دارد. این مساله نیازمند بررسی بیشتر است، بنابراین در این جا تنها نتایج مدلهای سادهی SFT-تقطیرشده را ارایه میکنیم.

۳. در نهایت، برای پیشرفت واقعی، هیچ چیز جایگزین مدلهای پایهی قویتر نمیشود.

هم مدل هوش مصنوعی دیپ سیک R1 و R1-Zero بر اساس DeepSeek-V3 ساخته شدهاند، اما در نهایت، دیپ سیک مجبور خواهد بود V4، V5 و فراتر از آن را توسعه دهد که هزینهی هنگفتی دارد. همین مساله برای اوپنایآی هم صادق است: فقط استفاده از GPT-5 برای بهبود سری o کافی نخواهد بود. آنها در نقطهای مجبور خواهند شد GPT-6 را آموزش دهند:

درحالیکه استراتژیهای تقطیر هم مقرونبهصرفه و هم موثر هستند، پیشرفت فراتر از مرزهای هوش، ممکن است همچنان به مدلهای پایهی قویتر و یادگیری تقویتی در مقیاس بزرگتر نیاز داشته باشد.

اگر بخواهیم همهی این ماجرا را در یک نمودار خلاصه کنیم، پیام اصلی این است:

🔹 مدلهای پایهی قویتر + تقطیر + RL = ترکیب برنده

- democratic vision for AI must prevail over an authoritarian one. ↩︎

- The United States currently has a lead in AI development, but continued leadership is far from guaranteed. ↩︎

- the People's Republic of China has said that it aims to become the global leader in AI by 2030. ↩︎

- هوش عمومی مصنوعی (به انگلیسی: Artificial general intelligence ) هوش ماشینی است که میتواند با موفقیت هر کار فکریای را که یک انسان قادر به انجام آن باشد، اجرا کند. این مساله هدف اصلی برخی از پژوهشهای حوزهی هوش مصنوعی و موضوعی رایج در داستانهای علمی و نیز آیندهپژوهی است. ↩︎

- Distillation ↩︎